引言

原文链接:https://yunsonbai.top/2020/01/16/log_collect/

1 | 随着业务的发展,为了满足越来越多的业务需求,逐渐从原来的单机到多机再到基于docker的集群,发展 |

简单介绍一下用到的组件/工具

filebeat

- 文档: 文档,我觉得这里边已经说的很清楚为啥使用filebeat做日志收集器了

- 优势:

- 基于golang的轻量级日志采集器,配置启动出奇的简单

- 按官方说法elastic专门为成千上万机器日志收集做的收集器

kafka

- 文档: 文档

- 优势:

- 应该说kafka的诞生就是为日志收集做服务的

- 几乎可以认为kafka集群没有qps上限,单机都能到10W/s的吞吐,完全分布式。[可怕]

- 好文推荐: Kafka 背景及架构介绍

ELK

- E: ElasticSearch

- 文档: 文档

- 优势: 高度可扩展的开源全文搜索和分析引擎,可快速、实时存储、搜索和分析数据。(网上太多了)

- 好文推荐: 图解elasticsearch原理,有点老我觉得不影响理解

- L: Logstash

- 文档: 文档

- 优势: 实时流水线功能,分析合并来源(MySQL、Redis、kafka)数据,并输出到目标(es、file等)存储地址

- 好文推荐: 上手Logstash

- K: kibana

- 文档: 文档

- 优势: 完备的前端展示

grafana

- 是什么: 可以理解和kibana一样的东西,出于个人的喜爱,它真的很黑炫酷

- 文档: 文档

其他说明

1 | 其实没有花太多篇幅介绍上边的组件的使用和原理,本文的分享重点不在这里,只是分享用什么样的架构来使用 |

架构情况说明

- 架构图:

- 实例数: 全部基于docker部署,各类角色的实例数过千

- 日志量: 日均日志约4.6亿条, 占空间约140G。

- 目前收集架构负载: 十几个es节点个位数负载,个位数logstash节点也几乎没有负载。

- 版本说明: filebeat、logstash、es、kibana版本要一致

组件使用注意点

filebeat

- 打包说明: 镜像在打包时,要添加上filebeat可执行文件(可在官网下载),可以使用supervisor管理服务。

- filebeat配置文件可参考以下例子:

1 | filebeat.prospectors: |

logstash

- 机器数量: 可以找几台虚机(4c+8G)启动,尽量个数和kafka的节点数一致。

- input和output: kafka(filebeat日志流向的kafka)和es集群

- 配置注意:

- pipeline.batch.size: 2000 # 达到多少个events后向目标地址输送数据

- pipeline.batch.delay: 10 # 等待多少秒向目标地址输送数据

1 | 两个配置不冲突,哪个满足了就触发向目标输送数据,我们的目标地就是es集群。 |

- 关于filter

1 | 一般会用到的有grok(正则切割日志)、json(json解析)、mutate(组合命令remove_field(去除无用字段)等等) |

- 配置样例

1 | input { |

关于es

- 注意点: 注意修改number_of_shards数量等于节点数,es的number_of_shards默认为5

1 | 跳过一次坑,没有修改number_of_shards,虽然机器多,但是日志散落不均匀导致总有es的某几个 |

关于数据展示

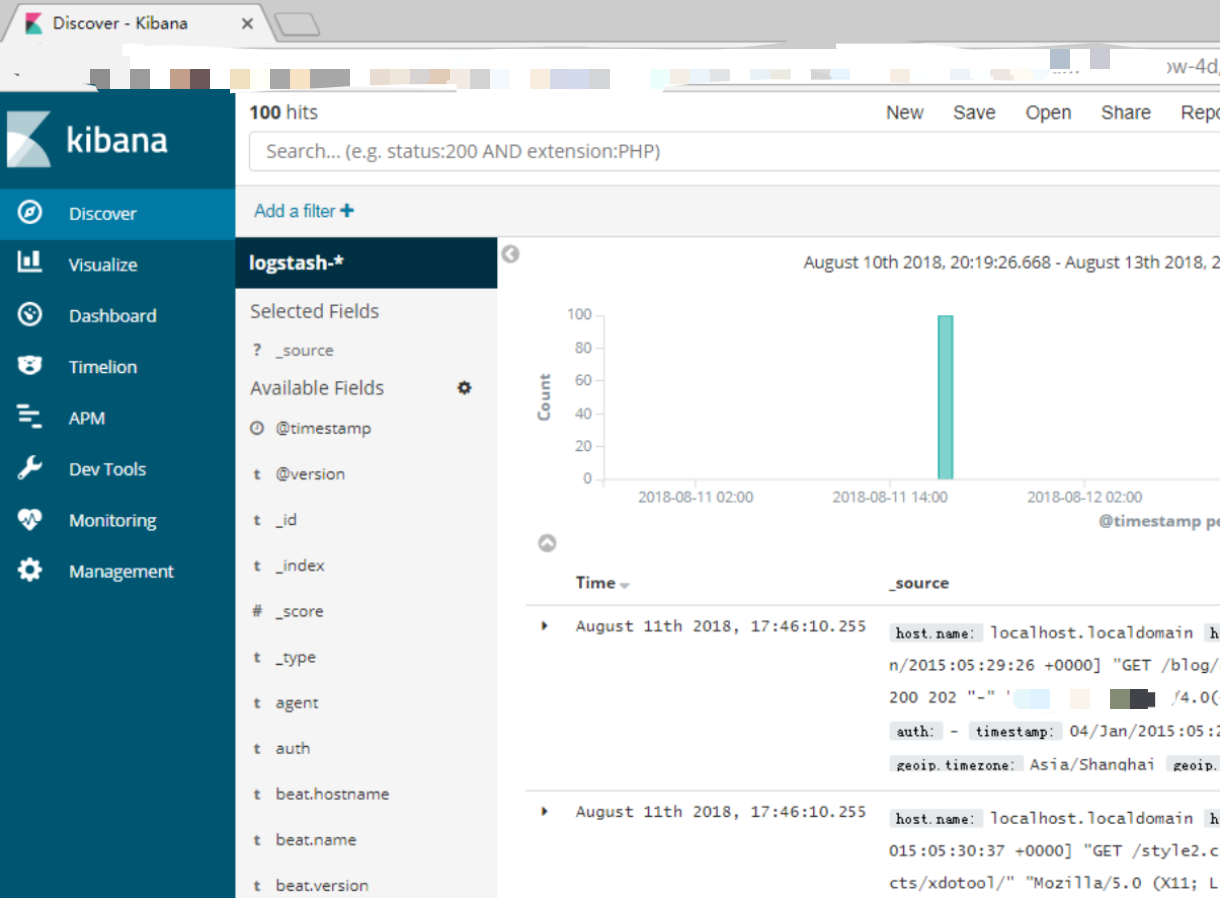

- kibana:一张老图

- grafana

![炫酷的图]](https://yunsonbai.top/images/grafana.png)

- 统计脚本: python、golang、java任选

总结

1 | 日志对于监控系统流量、提升系统性能、发现系统问题等有着十分重要的意义,可以说有些日志对于系统 |